简化的代价函数和梯度下降

- 简化代价函数

- 梯度下降

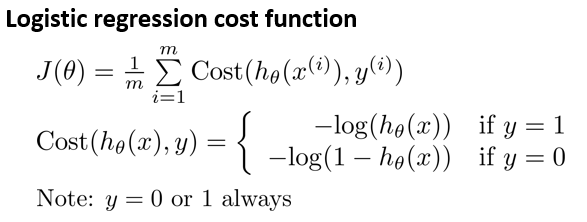

逻辑回归的代价函数:

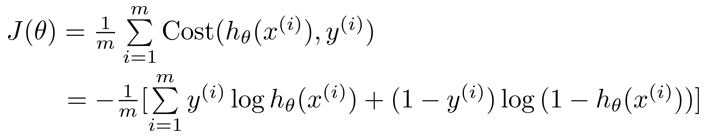

这个式子可以合并成:

要试图找出让 $J(\theta)$取得最小值的参数$\theta$。

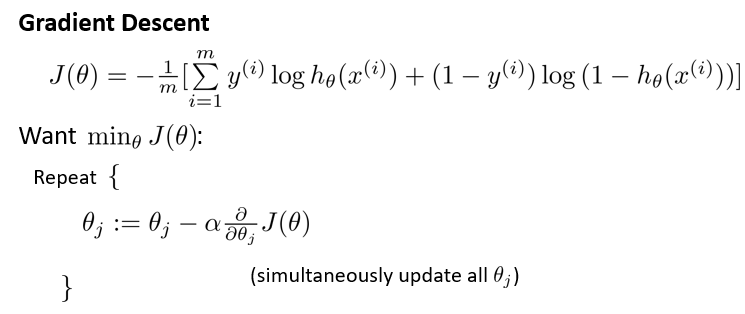

梯度下降

最小化代价函数的方法,是使用梯度下降法(gradient descent)。这是通常用的梯度下降法的模板:

反复更新每个参数,用这个式子减去学习率 α 乘以后面的微分项。求导后得到:

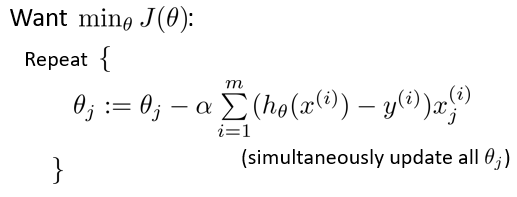

计算得到等式:

来它同时更新所有$\theta$的值。

这个更新规则和之前用来做线性回归梯度下降的式子是一样的, 但是假设的定义发生了变化。即使更新参数的规则看起来基本相同,但由于假设的定义发生了变化,所以逻辑函数的梯度下降,跟线性回归的梯度下降实际上是两个完全不同的东西。

牛刀小试

Todo: 列出你知道的梯度下降的技巧

答:监控梯度下降法以确保其收敛、参数向量化、特征缩放等